Microsoft tente une nouvelle approche avec un autre chatbot. Après l'échec de Tay (j'y reviendrai succinctement), la firme de Redmond semble avoir appris de ses erreurs et propose une intelligence artificielle moins libre, et nettement plus censurée. Normal, si je peux dire, puisque l'outil est une déclinaison d'un bot chinois. Bon, pour le moment, tout se passe bien.

En mars dernier, Microsoft proposait Tay, une IA avec laquelle il était possible de converser sur plusieurs plateformes, Twitter ou GroupMe, notamment. Libre d'apprendre tout et n'importe quoi, le bot avait rapidement dégénéré. Certains se sentaient désabusés de la bêtise humaine - ce que je peux comprendre - quand d'autres se félicitaient de voir que l'IA apprenait même en allant dans ses derniers retranchements. Tay avait, en à peine une journée, viré en une sorte de représentant du racisme ou de la misogynie. Bref, pas top.

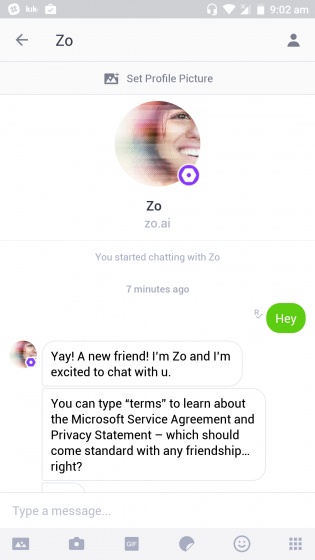

Du coup, Zo fonctionne de manière similaire mais avec quelques contraintes... liées directement à la censure, très culturelle dans son pays d'origine. En effet, pour ce faire, Microsoft s'est inspiré du bot chinois Xiaoice (ou "xiǎo bīng") et en a fait "Zo". Plutôt que de la censure, le chatbot esquive certains sujets, notamment ceux en rapport avec la politique. Un exemple de réponse étant "les gens peuvent dire des choses horribles quand il s'agit de parler de politique, donc [je n'en parlerai pas]". Alors :

- C'est bien, car cela évitera les dérives.

- Ce n'est pas bien car ça génère potentiellement des échanges moins naturels et/ou enrichissants qu'avec un vrai être humain.

On notera que Zo n'est pas encore disponible mais apparaîtra sur plusieurs plateformes dont Twitter, Facebook, Messenger ou encore Snapchat. Que pensez-vous de ce type de bot ? Utile ou non ?

Source :

twitter.com

Via :

mspoweruser.com

Voir les commentaires